[패스트캠퍼스 수강 후기] 인공지능강의 100% 환급 챌린지 43회차 미션

인공지능강의

PART 5) 딥러닝 최신 트렌드

03. Ch 01. Image Classification - 03. 딥러닝 Classification 배경

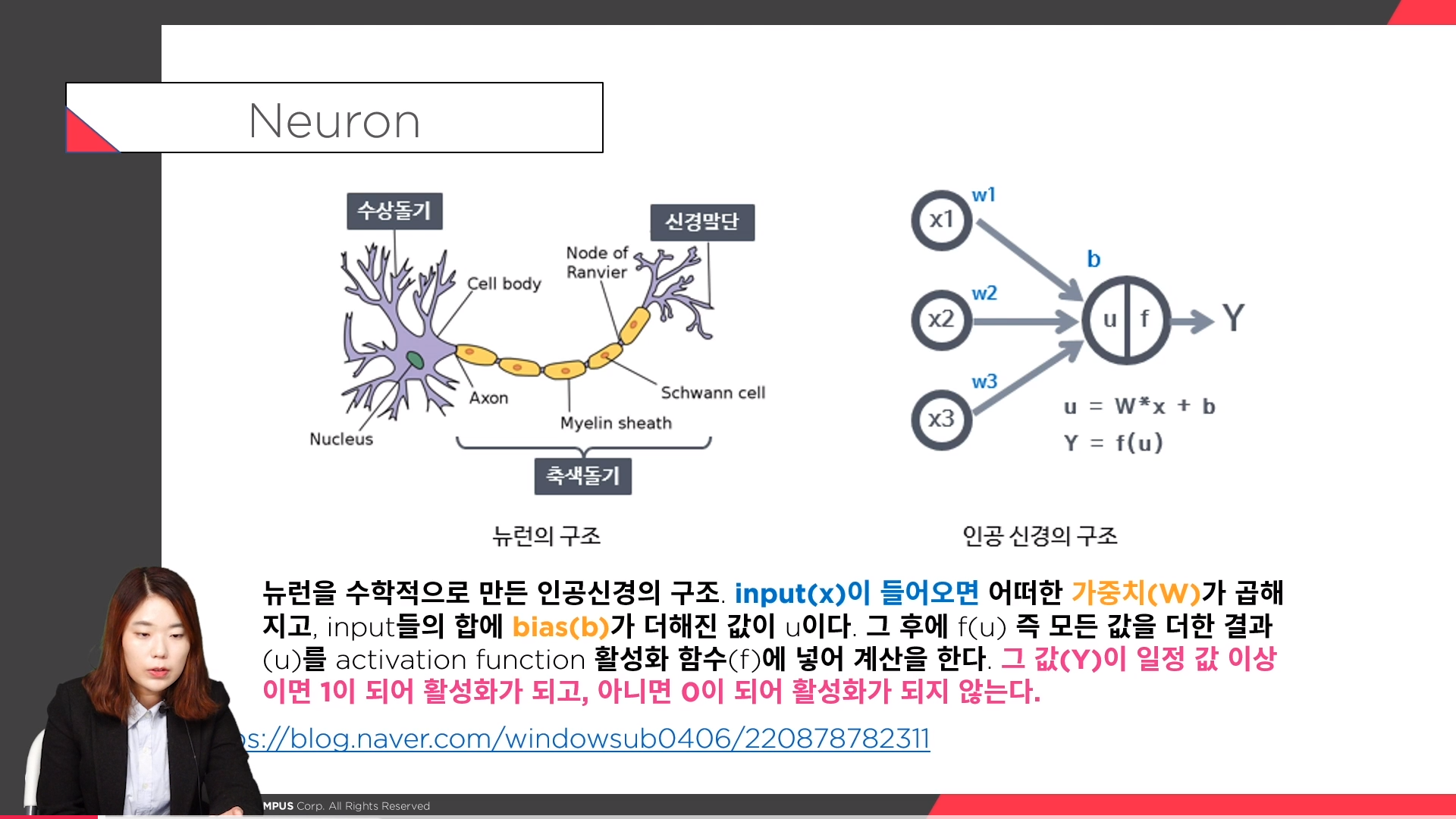

Neuron

뉴런을 수학적으로 만든 인공신경의 구조를 보자. input(x)이 들어오면 어떠한 가중치 (W)가 곱해지고, input들의 합에 bias(b)가 더해진 값이 u이다. 그 후에 f(u) 즉 모든 값을 더한 결과(u)를 activation function 활성화 함수(f)에 넣어 계산을 한다. 그 값(Y)이 일정 값 이상이면 1이 되어 활성화가 되고, 아니면 0이 되어 활성화가 되지 않는다.

Deep Learning History

1세대 : 인공신경망(Artificial Neural Networks-ANNs-) 개념과 퍼셉트론(Perceptron)의 등장 (1943~1986년)

퍼셉트론은 단순한 선형 분류기에 불과하며 간단한 XOR 분류조차 수행할 수 없다고 지적하였다.

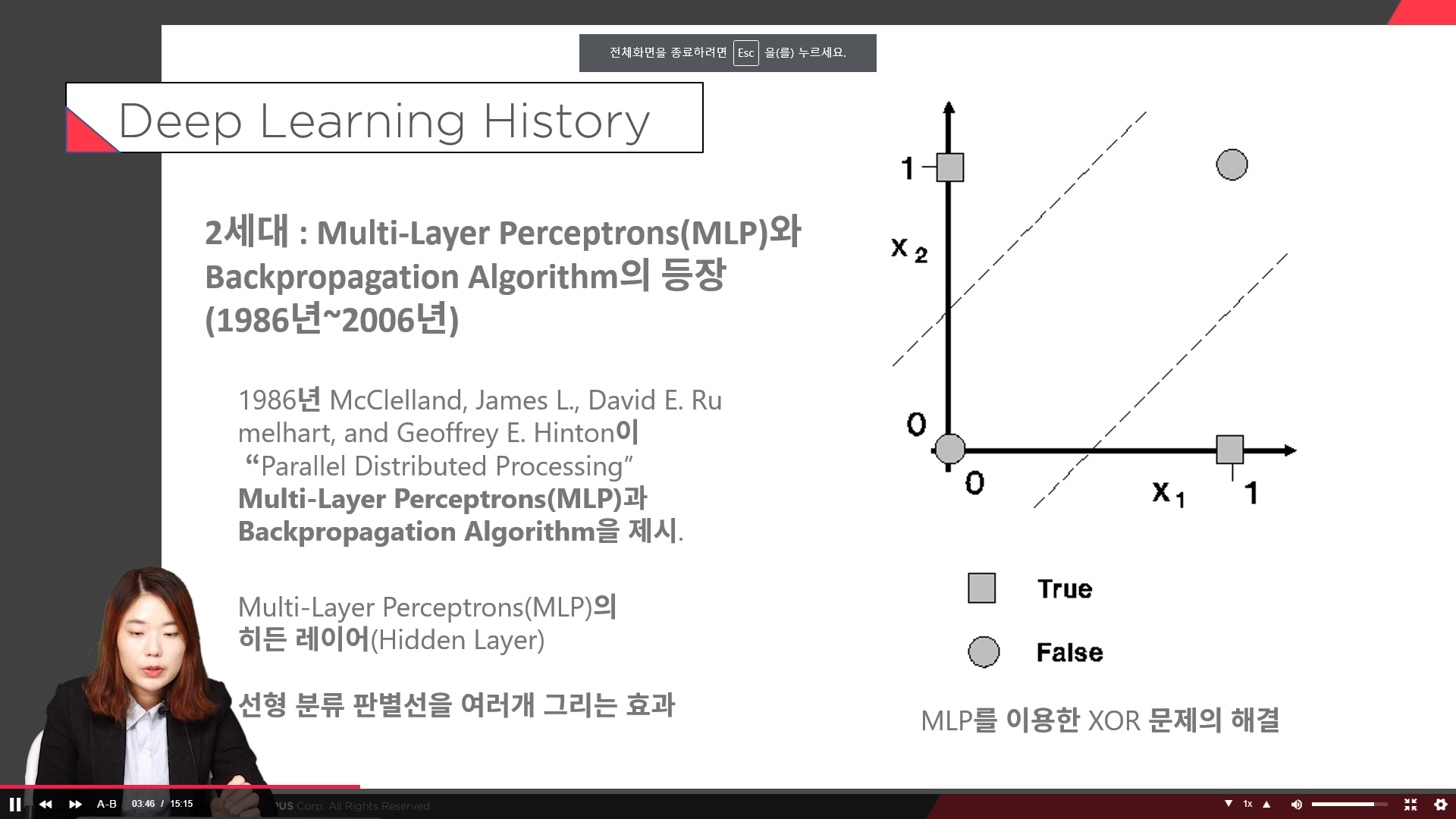

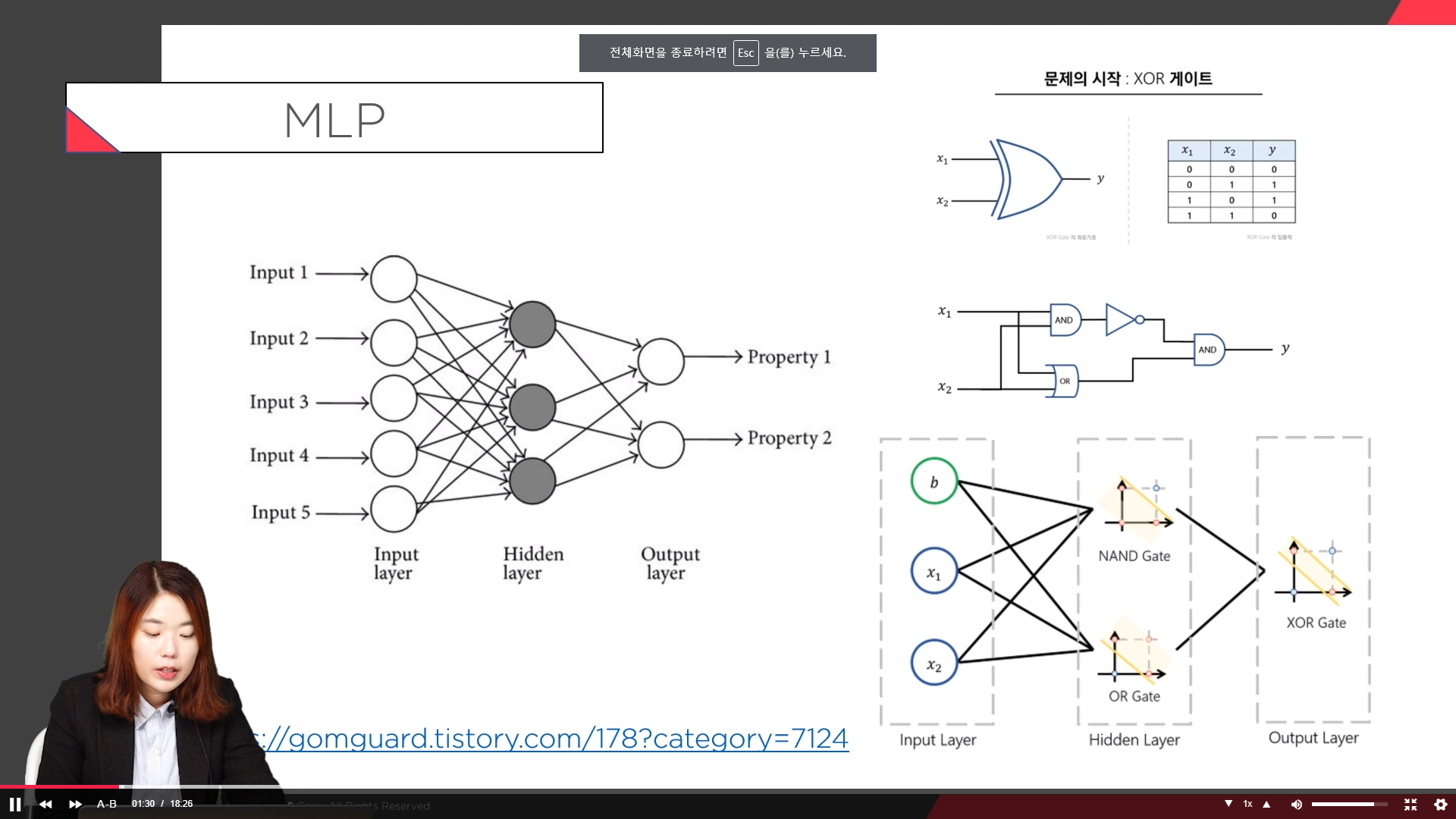

2세대 : Multi-Layer Perceptrons(MLP)와 Backpropagation Algorithm의 등장 (1986년~2006년)

선형 분류 판별선을 여러개 그리는 효과

MLP와 Backpropagation Algorithm을 Convolu tion과 결합하여 필기숫자 인식(MNIST) 문제에 적용

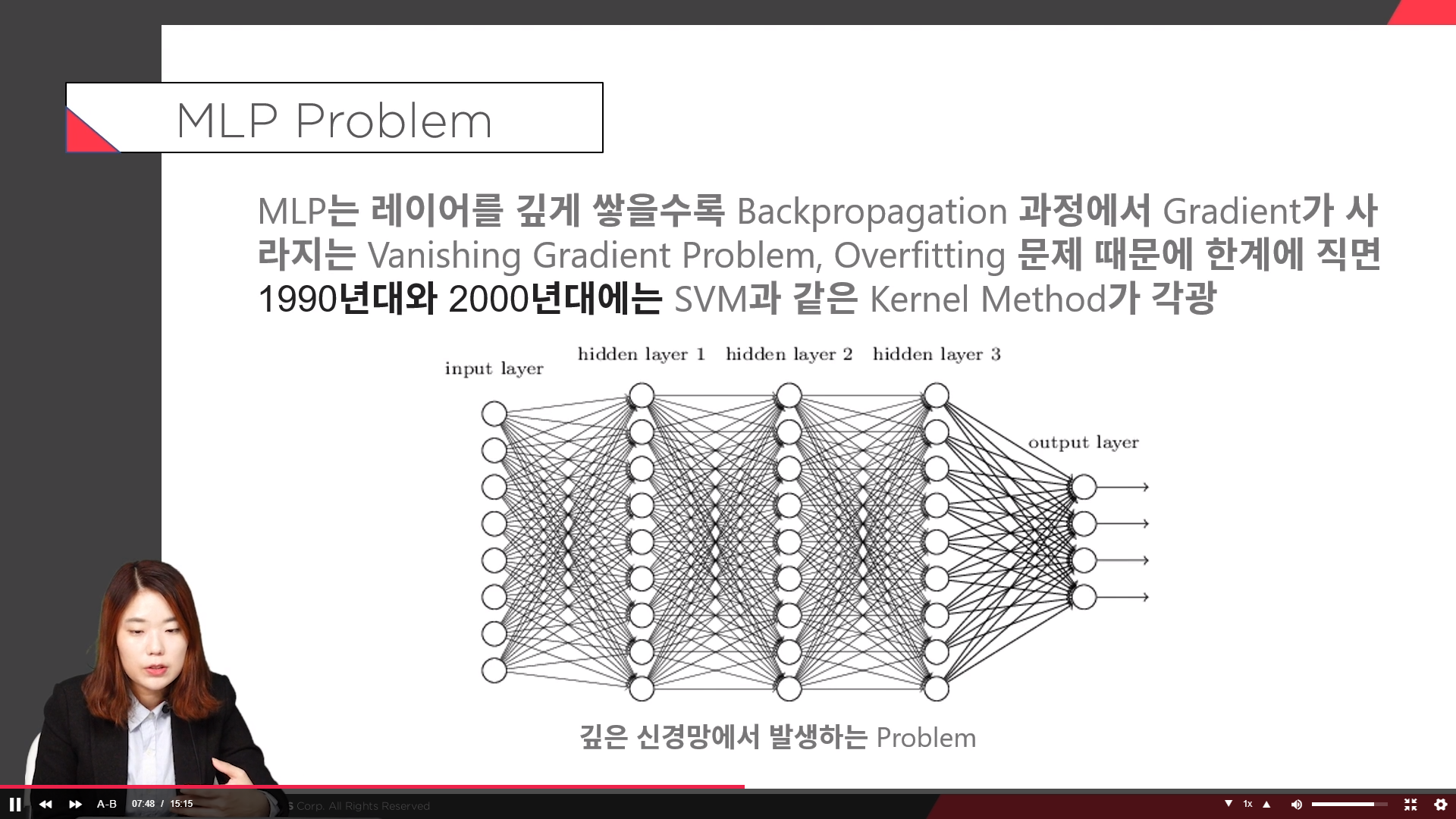

MLP는 레이어를 깊게 쌓을수록 Backpropagation 과정에서 Gradient가 사라지는 Vanishing Gradient Problem, Overfitting 문제 때문에 한계에 직면 90년대와 2000년대에는 SVM과 같은 Kernel Method가 각광 인공신경망 연구는 다시 인공지능 학계의 주류에서 밀려나나게 된다

04. Ch 01. Image Classification - 04. LeNet, AlexNet

CNN

Feature extraction

특징을 추출하기 위한 단계 -> Receptive field , Convolution filter

Shift and distortion invariance

Topology 변화에 영향을 받지 않기 위한 단계-> subsampling(max pooling)

Classification

분류기 단계 -> fully connected output

AlexNet

1. GPU 병렬연산, Group Conv

2. ReLU 함수의 사용

활성화 함수로는 LeNet-5에서 사용되었던 Tanh함수 대신에 ReLU 함수가 사용. 같은 정확도를 유지하면서 Tanh을 사용하는 것보다 6배나 빠르다고 한다.

3. Dropout의 사용

Overfitting을 방지하기위한 dropout사용. dropout이란 fully-connected layer의 뉴런 중 일부를 생략하면서 학습을 진행. 몇몇 뉴런의 값을 0으로 바꿔버린다. dropout은 훈련시에 적용하며 테스트 시에는 모든 뉴런을 사용한다.

4. Overlapping Pooling

LeNet-5의 경우 평균 풀링(averagepooling)이 사용된 반면,AlexNet에서는 최대 풀링(maxpooling)이 사용. LeNet-5는 non-overlapping평균 풀링을 사용한 것이고, AlexNet은 overlapping최대 풀링을 사용한 것이다.

5. Data Augmentation

과적합을 막기 위해 dataaugmentation이란 방법을 통해 데이터의 양을 늘렸다. 이미지를 좌우 반전시키거나, AlexNet이 허용하는 입력 이미지 크기인 224x224x3보다 좀 더 큰 이미지를 조금씩 다르게 잘 라서 224x224x3으로 만들어줘서 여러장을 만들어낸다.

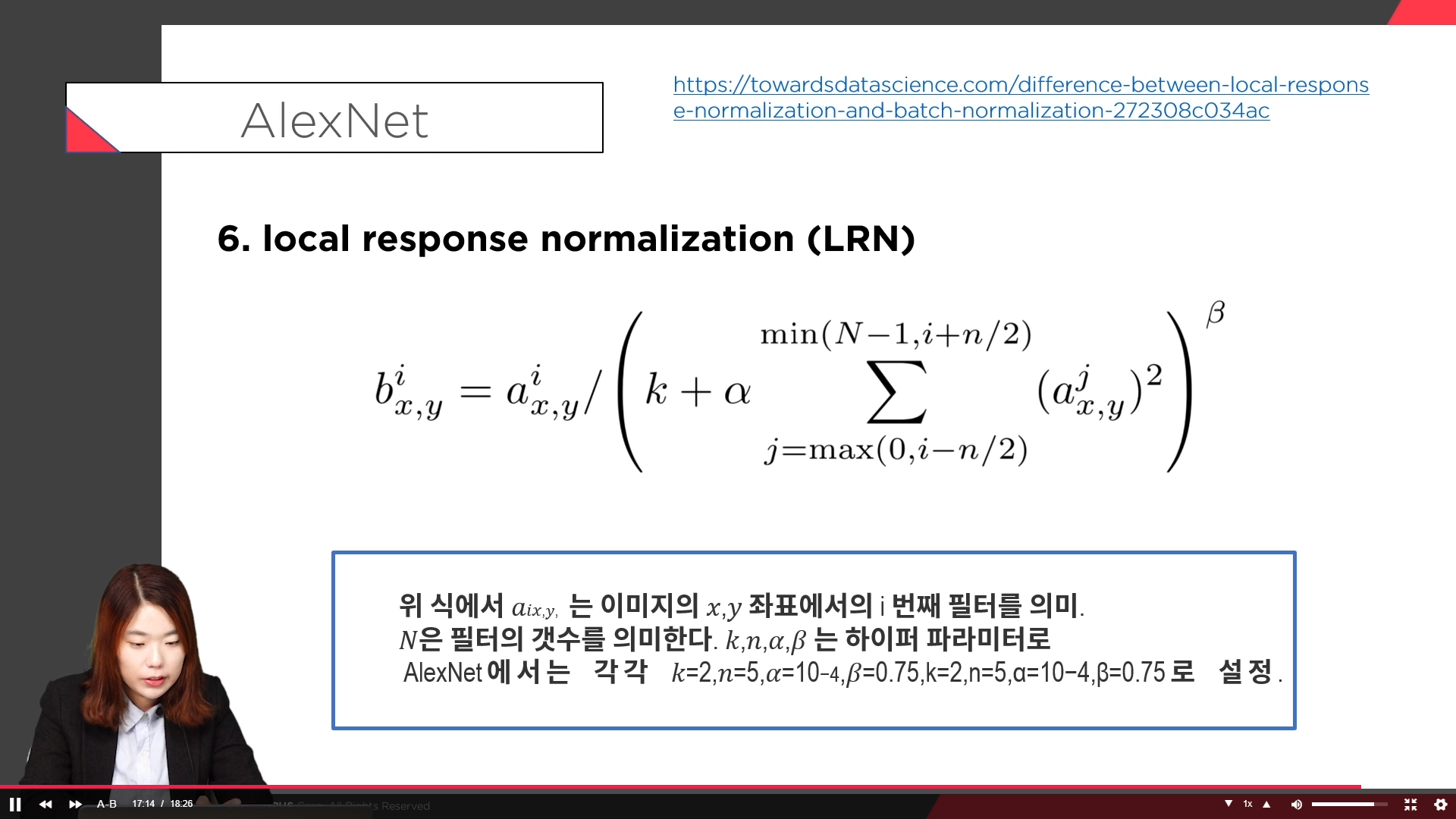

6. local response normalization (LRN)

딥러닝/인공지능 올인원 패키지 Online. | 패스트캠퍼스

Tensorflow2.0부터 Pytorch까지 딥러닝 대표 프레임워크를 정복하기. 생활 깊숙이 침투한 인공지능, 그 중심엔 딥러닝이 있습니다. 가장 강력한 머신러닝의 툴로서 주목받는 딥러닝은 생각보다 어려��

www.fastcampus.co.kr